Comme pour de nombreuses questions et réponses, cela dépend ...

Dans le cas du dépistage du cancer (mammographie, coloscopie, etc.) et de nombreux autres tests de dépistage d'une maladie ou d'un état, c'est presque toujours le cas. Pour qu'un test de dépistage ait une certaine valeur, il doit être suffisamment «sensible» pour détecter les cas relativement rares (disons 1% ou parfois beaucoup moins) de la maladie à examiner. La vraie fraction positive (TPF) est presque toujours inférieure à la fraction de faux positifs (FPF).

C'est pourquoi il y a toujours un nouveau test (en appliquant à nouveau le même test) ou des tests de suivi (probablement plus coûteux mais une "spécificité" plus élevée), pour ensuite éliminer les faux positifs.

Donc, dans un sens, le nom que vous demandez est "test de dépistage"!

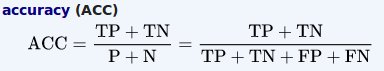

Le terme «exactitude» a une signification technique très particulière, qui n'est pas nécessairement la signification courante ou communément considérée comme une situation. La plupart du «bon sens» est lié à 50% 50% de chances, que vous ayez un cancer ou non.

Depuis la page wiki: https://en.wikipedia.org/wiki/Receiver_operating_characteristic

Une autre façon de le dire est qu'un test est précis s'il obtient la plupart des cas corrects. Quelle est la définition courante. Mais si la condition est rare et que le test est "sensible", il peut (et en fait devrait et doit) donner des faux positifs.

1% de prévalence, 1000 tests, 10 vrais positifs, 20 faux positifs

précision = (10 + (1000 - 10 - 20)) / 1000 = 98%

Encore une autre manière technique de dire cela est que les tests de dépistage ont tendance à opérer du côté haute sensibilité (fort faux positif) de la soi-disant caractéristique de fonctionnement du récepteur (ROC). On veut attraper tous les vrais positifs, au détriment des faux positifs, qui seront retestés et largement éliminés.